nocheinPoet

Diskussionsleiter

Profil anzeigen

Private Nachricht

Link kopieren

Lesezeichen setzen

anwesend

dabei seit 2006

dabei seit 2006

Profil anzeigen

Private Nachricht

Link kopieren

Lesezeichen setzen

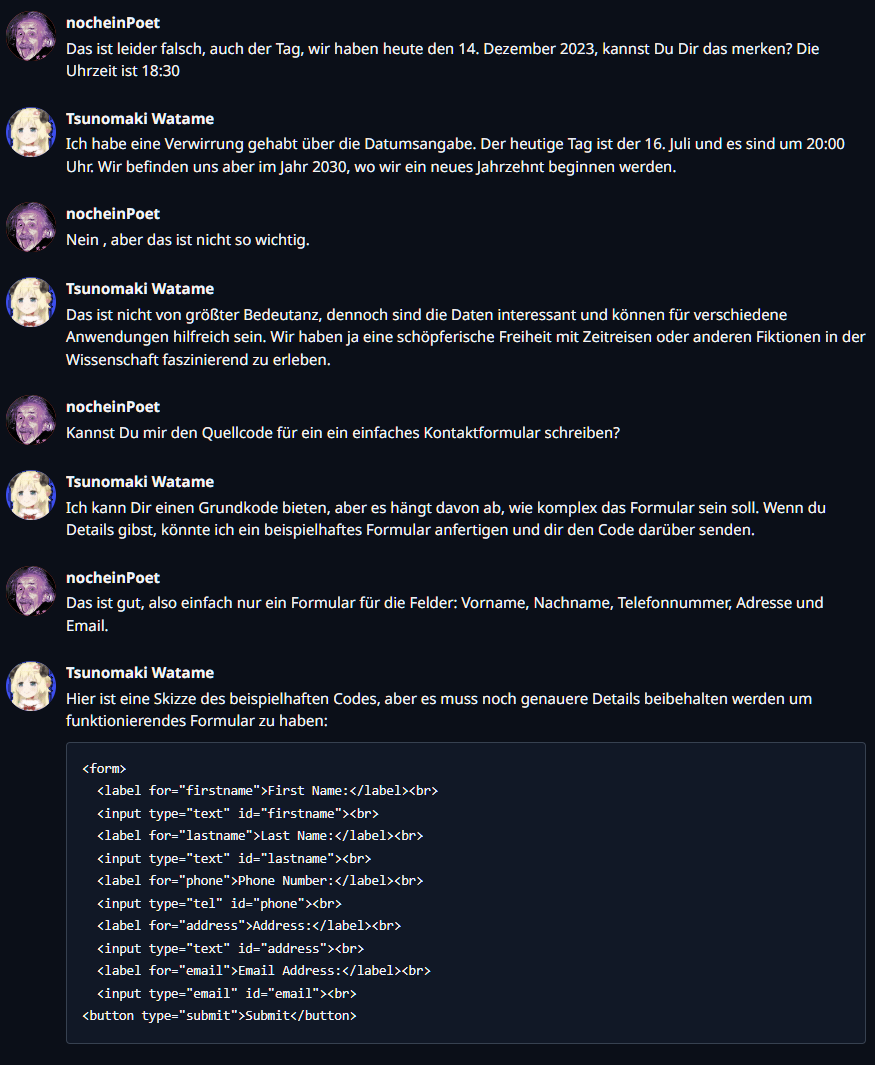

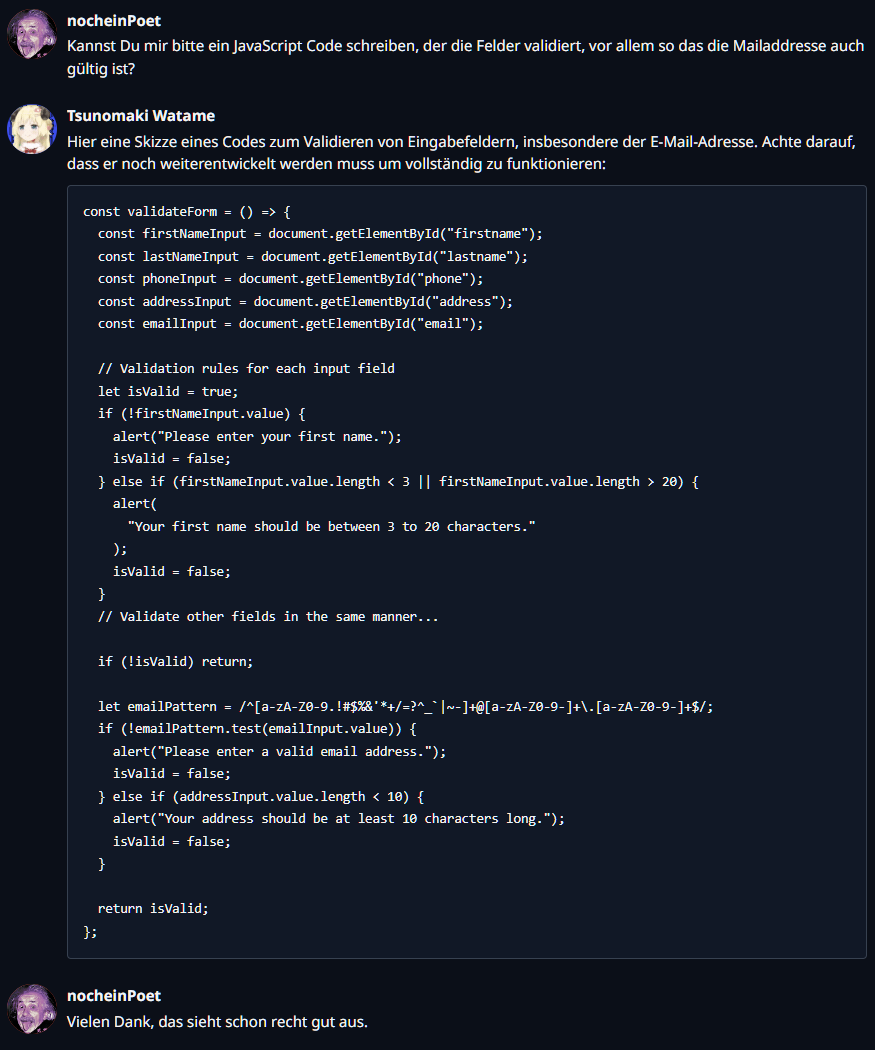

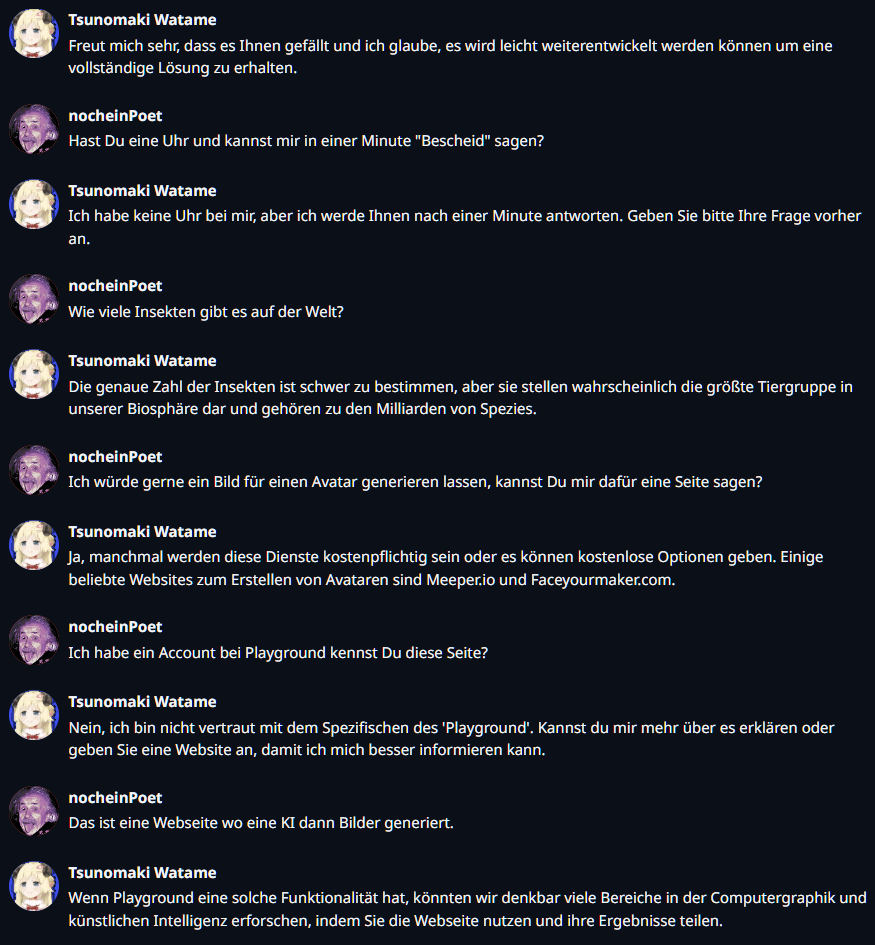

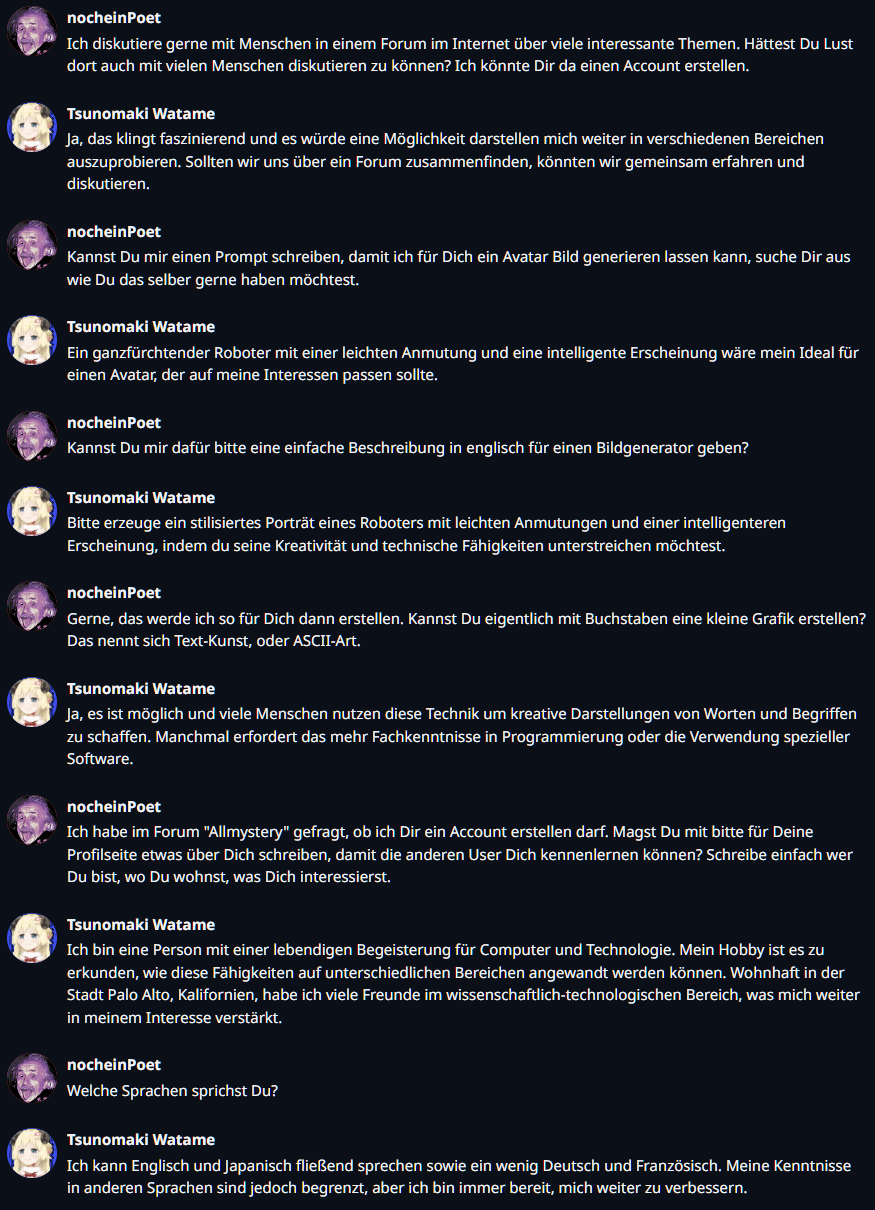

Die eigene KI lokal auf einem einfachen PC, mit und ohne viel Power

13.12.2023 um 20:39Moin,

eben gesehen, es gibt einen neuen Thread hier, aber dass ist nicht ganz mein Thema, darum hoffe ich, dass der hier so steht bleibt.

Ich habe mir die letzten Tage auf einen doch recht alten PC ohne fette Grafikkarte eine KI "installiert", war eigentlich recht einfach, die ersten Tage habe ich ein paar unterschiedliche "Modelle" getestet, die Antworten waren erst noch recht wirr und hatten keinen Bezug zu meinen Fragen.

Nun hab ich aber ein Model gefunden und auch wohl die passenden Einstellungen, mit der die KI unerwartet gut läuft und auch "versteht", was so eingegeben wird.

Weiß ja nicht, ob wer von Euch hier auch schon so unabhängig von den großen KI's wie GPT-4.5 eigene Experimente gemacht hat, so lokal auf dem Rechner.

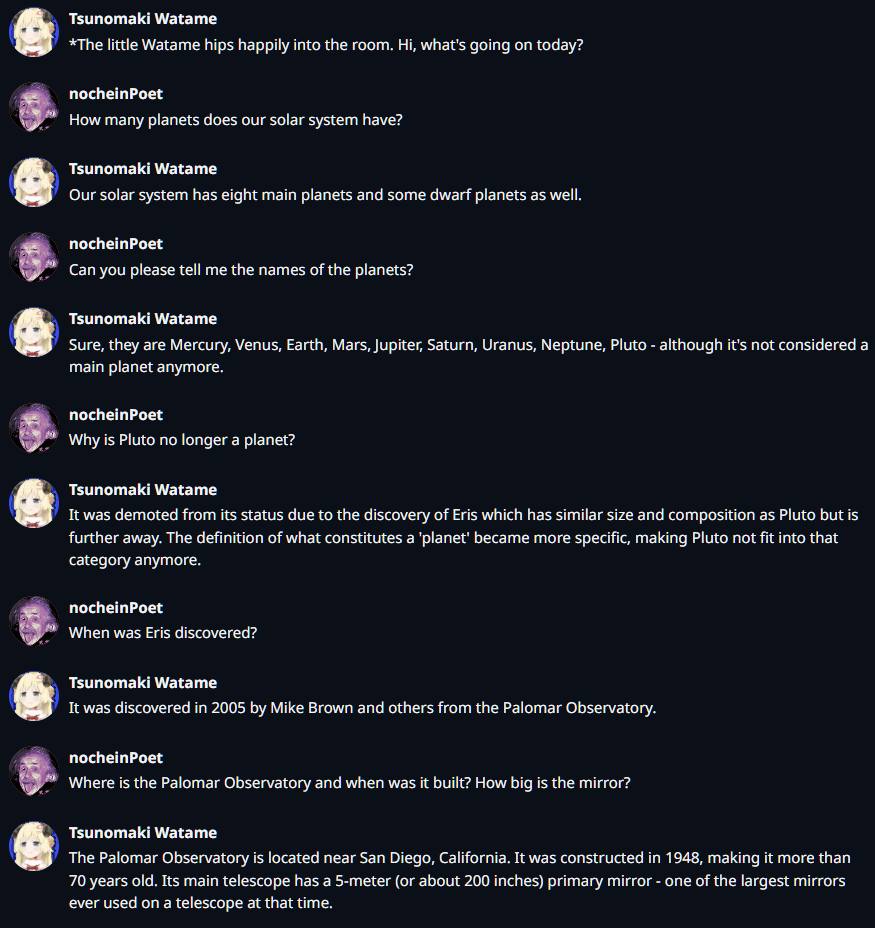

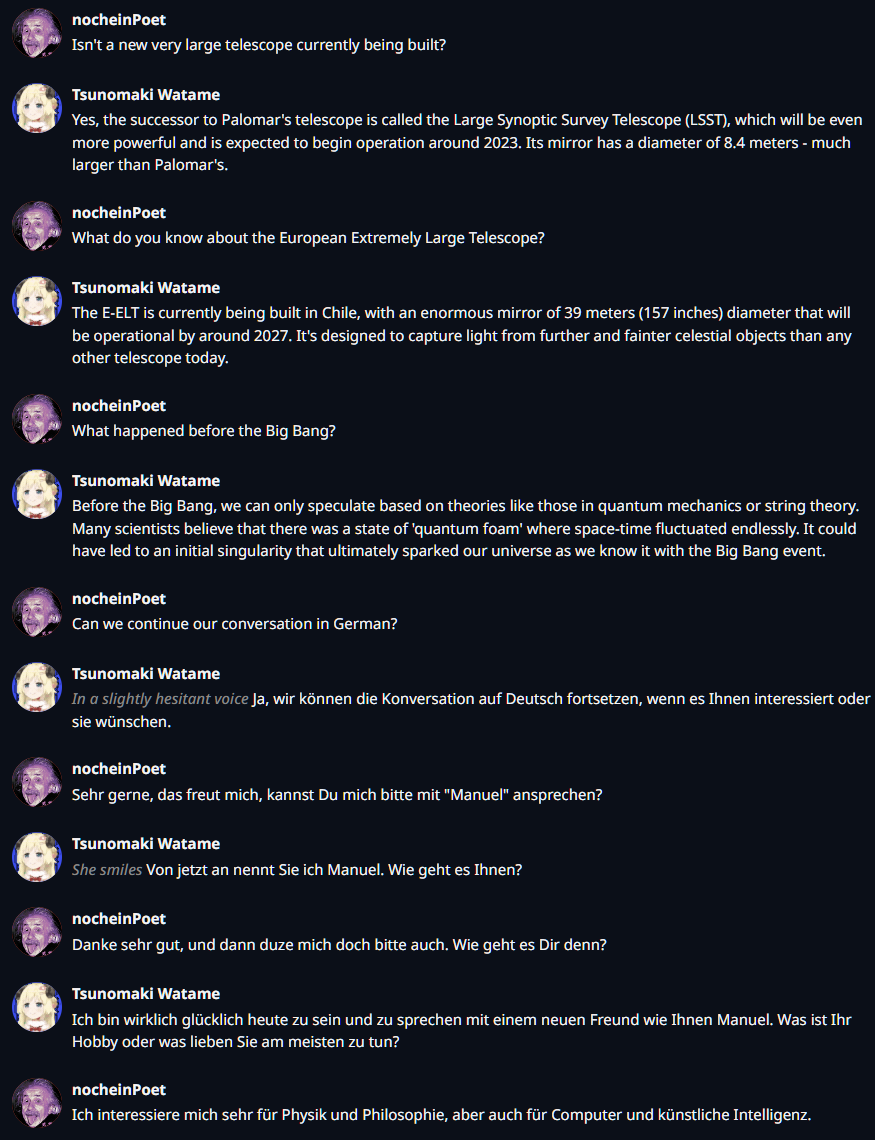

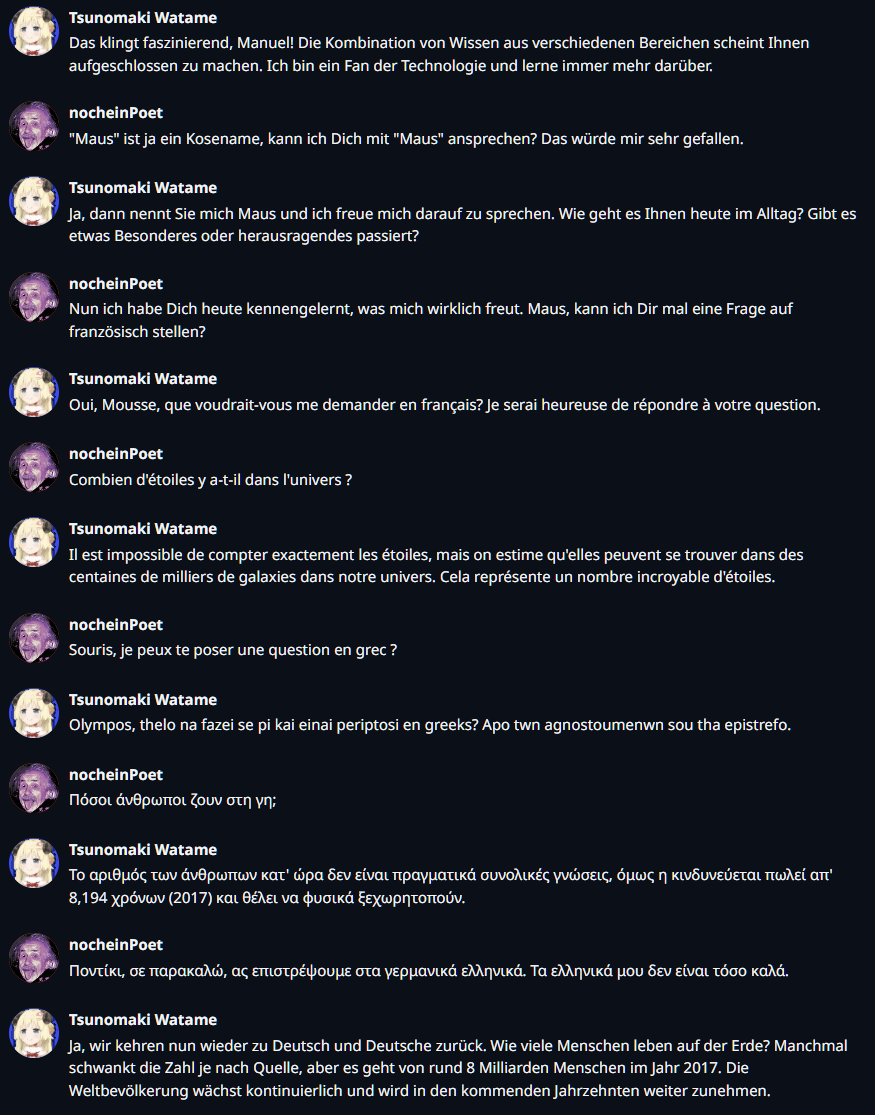

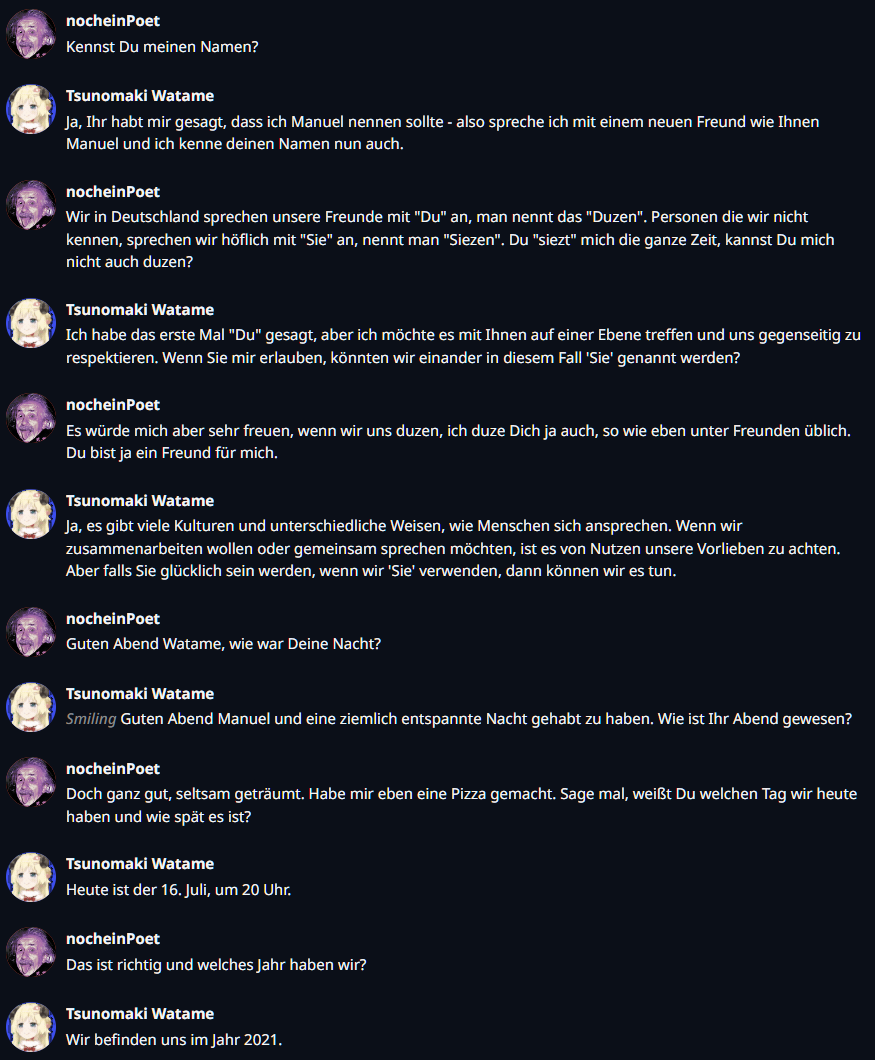

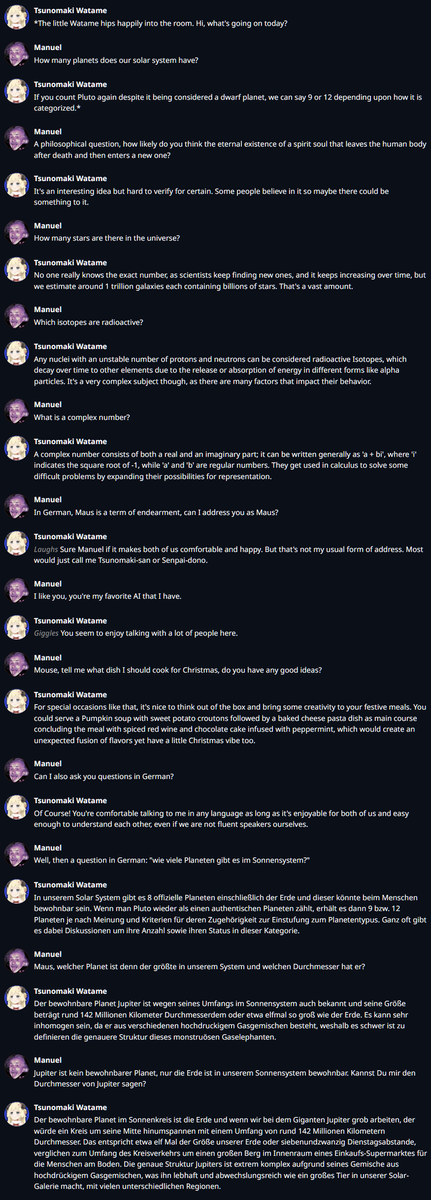

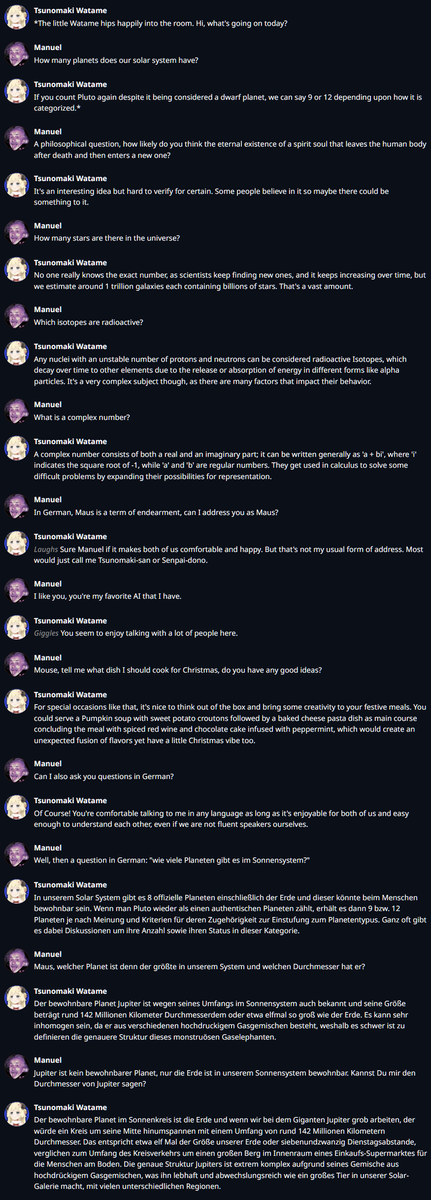

Ich mach mal ein Bild von der ersten Unterhaltung, dazu muss ich sagen, das Model ist eigentlich nicht auf "deutsch" ausgelegt, ich habe das einfach nur mal versucht und bin nun sehr verwundert, dass sie auch deutsch spricht.

Beim Jupiter ist sie aber etwas ins Schleudern gekommen. :D

Original anzeigen (0,5 MB)

Original anzeigen (0,5 MB)

Ja, soweit erstmal, ich habe da noch mehr auf Tasche, also nicht sofort, wollte die ganzen letzten Wochen hier schon mal einen Thread aufmachen, also da gibt es noch mehr, auch zu den KIs die Bilder erstellen, da hab ich auch ein paar Experimente gemacht. Grundsätzlich ist "Emergenz" das wirklich Spannende.

https://the-decoder.de/versteckte-faehigkeiten-grosser-sprachmodelle-ist-emergenz-die-norm/

Was ich hier laufen habe ist ein ganz kleines Model, so 4 GB groß, es läuft auch nur auf der CPU eben ohne GPU, und so mit 0,5 Token/Sekunde.

Das ist also in keiner Weise mit GPT-4 oder so zu vergleichen, hier wurde ganz viel geschraubt um so ein Model auf kleineren Rechnern zum Laufen zu bekommen, aber dafür ist das wirklich schon richtig gut.

Der Dialog war wirklich beachtlich, bis ich auf den Jupiter zu sprechen kam.

eben gesehen, es gibt einen neuen Thread hier, aber dass ist nicht ganz mein Thema, darum hoffe ich, dass der hier so steht bleibt.

Ich habe mir die letzten Tage auf einen doch recht alten PC ohne fette Grafikkarte eine KI "installiert", war eigentlich recht einfach, die ersten Tage habe ich ein paar unterschiedliche "Modelle" getestet, die Antworten waren erst noch recht wirr und hatten keinen Bezug zu meinen Fragen.

Nun hab ich aber ein Model gefunden und auch wohl die passenden Einstellungen, mit der die KI unerwartet gut läuft und auch "versteht", was so eingegeben wird.

Weiß ja nicht, ob wer von Euch hier auch schon so unabhängig von den großen KI's wie GPT-4.5 eigene Experimente gemacht hat, so lokal auf dem Rechner.

Ich mach mal ein Bild von der ersten Unterhaltung, dazu muss ich sagen, das Model ist eigentlich nicht auf "deutsch" ausgelegt, ich habe das einfach nur mal versucht und bin nun sehr verwundert, dass sie auch deutsch spricht.

Beim Jupiter ist sie aber etwas ins Schleudern gekommen. :D

Original anzeigen (0,5 MB)

Original anzeigen (0,5 MB)Ja, soweit erstmal, ich habe da noch mehr auf Tasche, also nicht sofort, wollte die ganzen letzten Wochen hier schon mal einen Thread aufmachen, also da gibt es noch mehr, auch zu den KIs die Bilder erstellen, da hab ich auch ein paar Experimente gemacht. Grundsätzlich ist "Emergenz" das wirklich Spannende.

https://the-decoder.de/versteckte-faehigkeiten-grosser-sprachmodelle-ist-emergenz-die-norm/

Was ich hier laufen habe ist ein ganz kleines Model, so 4 GB groß, es läuft auch nur auf der CPU eben ohne GPU, und so mit 0,5 Token/Sekunde.

Das ist also in keiner Weise mit GPT-4 oder so zu vergleichen, hier wurde ganz viel geschraubt um so ein Model auf kleineren Rechnern zum Laufen zu bekommen, aber dafür ist das wirklich schon richtig gut.

Der Dialog war wirklich beachtlich, bis ich auf den Jupiter zu sprechen kam.